В статье рассказывается:

- Что такое Hadoop

- Краткая история развития Hadoop

- Поставщики Hadoop

- Из чего состоит Hadoop

- Основные функции Hadoop

- Кому нужен Hadoop

- Часто задаваемые вопросы о Hadoop

-

Пройди тест и узнай, какая сфера тебе подходит:

айти, дизайн или маркетинг.Бесплатно от Geekbrains

Что такое Hadoop

Многие начинающие аналитики хотят понять, что такое Apache Hadoop («Хадуп»). Это ПО представляет собой набор инструментов, применяющихся для работы с большими данными. С его помощью можно собирать, хранить и выполнять распределенную обработку огромного количества непрерывно поступающей информации (несколько сотен терабайт).

Hadoop используется для построения так называемых озер данных. Речь идет об объемных хранилищах, внутри которых содержится неструктурированная информация, которая будет применяться для последующей аналитики.

Принцип работы Хадуп основан на распределении данных (MapReduce). Система сформирована из нескольких кластеров, которые представляют собой подсервера, или узлов, применяющихся в качестве единого ресурса. Если кластер принимает на себя крупную задачу, то Хадуп разделяет ее на несколько мелких подзадач, каждая из которой выполняется на определенном узле. Такой подход дает возможность решать целый ряд задач одновременно. Кроме того, система гораздо быстрее выполняет свою работу.

входят в ТОП-30 с доходом

от 210 000 ₽/мес

Скачивайте и используйте уже сегодня:

Топ-30 самых востребованных и высокооплачиваемых профессий 2023

Поможет разобраться в актуальной ситуации на рынке труда

Подборка 50+ бесплатных нейросетей для упрощения работы и увеличения заработка

Только проверенные нейросети с доступом из России и свободным использованием

ТОП-100 площадок для поиска работы от GeekBrains

Список проверенных ресурсов реальных вакансий с доходом от 210 000 ₽

Hadoop представляет собой open-source-продукт. За его использование не нужно платить. Пользователь может корректировать набор инструментов для тех или иных бизнес-задач:

- Хранение переписок пользователей соцсети. Речь идет об огромном количестве информации, которая содержит текстовые сообщения, эмодзи, видео, изображения, аудио. Все эти данные разнородны и не структурированы. Однако соцсеть может хранить переписки в Hadoop. Это позволяет извлекать нужную информацию для тех или иных целей.

- Хранение сведений о транзакциях. Это может понадобится компании, специализирующейся на эквайринге платежей. В день осуществляется несколько миллионов однотипных транзакций. При этом их скорость настолько высока, что базы данных не успевают все записывать. В таком случае можно воспользоваться Hadoop и решить проблему.

- Хранение информации о заказах. К примеру, крупный распределенный сервис доставки еды ежедневно отправляет несколько миллионов заказов по всей России. Все сведения о заказах, которые крайне важны для нормального функционирования приложения, отправляются в базы данных. Эту информацию необходимо постоянно анализировать, чтобы усовершенствовать работу программы. При использовании Hadoop обычные базы данных не применяются. Кроме того, снижается вероятность возникновения сбоев приложения.

Краткая история развития Hadoop

Сама технология Hadoop была создана почти 15 лет назад. С тех пор она постоянно совершенствовалась. Рассмотрим основные этапы развития инструмента:

- 2005 год. Работники компании Google Джеффри Дин и Санжай Гемават написали статью о вычислительной концепции MapReduce. Публикацией заинтересовался Дуг Каттинг. Он решил запустить собственный проект. Майк Кафарела и сам Дуг осуществляли разработку в режиме частичной занятости. Цель заключалась в создании программной инфраструктуры распределённых вычислений для свободной поисковой машины на Java. Хадупом ребенок основателя проекта называл своего игрушечного слоненка. В результате набор утилит стали именовать «железным слоном». Логотип в виде этого животного – еще одна отличительная характеристика проекта.

- 2006 год. Дуг Каттинг был приглашен в корпорацию Он возглавил команду разработчиков распределённых вычислений, которая была специально организована для этой задачи. Таким образом, Хадуп выделился в отдельный проект.

- 2008 год. Компания Yahoo решила запустить кластерную поисковую машину на 10 000 процессорных ядер. Управление осуществлялось именно Hadoop, который стал проектом верхнего уровня системы проектов Apache Software Foundation. В этом же году был поставлен мировой рекорд производительности в сортировке информации: всего за 209 секунд кластер из 910 узлов обработал 1 Тбайт данных. Затем технология начала применяться в Last.fm, The New York Times, облачных сервисах Amazon EC2.

- 2010 год. Apache Software Foundation получила от компании Google права на применение технологии MapReduce. Хадуп начал позиционироваться в качестве важнейшей технологии, позволяющей обрабатывать и хранить Big Data. В то же время началось формирование Hadoop-экосистемы. Появились некоторые важные продукты, например, Avro, HBase, Hive, Pig, Zookeeper. Эти решения упрощали операции, связанные с управлением информацией и распределенными приложениями, а также анализом данных.

- 2011 год. Проект получил ежегодную инновационную награду медиагруппы Guardian за универсальный подход к хранению и обработке распределенных данных («швейцарский нож XXI века»).

- 2013 год. В релизе Хадуп 2.0 появился модуль YARN. Он существенно расширил парадигму MapReduce и сделал распределенные системы более надежными и масштабируемыми.

Поставщики Hadoop

Как уже было отмечено, Хадуп представляет собой проект верхнего уровня компании Apache Software Foundation. Данный продукт является основным дистрибутивом и центральным репозиторием для всех наработок.

Однако для установки этого дистрибутива на кластер необходимо настроить машины, вручную установить пакеты, скорректировать множество файлов конфигурации и выполнить другие действия. Еще одна проблема – большое количество неполной или устаревшей документации. Из-за этого многие компании предпочитают дистрибутивы следующих компаний:

- Cloudera. Данная организация выпустила CDH (Cloudera Distribution including Apache Hadoop), представляющий собой набор наиболее распространенных инструментов из инфраструктуры Хадуп под управлением Cloudera Manager. Менеджеру необходимо развернуть кластер, установить все его элементы, а затем проводить мониторинг ПО. У Cloudera есть и другие решения (к примеру, Impala). Компания часто генерирует новые фичи, хоть от этого и снижается стабильность. Дуг Каттинг (основатель Хадуп) работает в Cloudera.

Читайте также!

Работа в Google Colab: преимущества и недостаткиПодробнее

- Hortonworks. Ключевой продукт – HDP (Hortonworks Data Platform). Компания активно развивает продукты Apache, а не разрабатывает собственные решения. К примеру, она применяет Apache Ambari, а не Cloudera Manager и Apache Hive вместо

- MapR. Отличительная особенность данной компании заключается в том, что основным источником доходов для нее является не консалтинг и партнерские программы, как у Hortonworks и Cloudera, а продажа собственных решений. Преимуществ MapR является большое количество оптимизаций. Кроме того, имеется партнерская программа с Amazon. Однако в бесплатной версии (M3) нет некоторых функций. MapR представляет собой основного идеолога и важнейшего разработчика Apache Drill.

Из чего состоит Hadoop

Хадуп разработан на языке Java. Команда использовала вычислительную парадигму MapReduce, которая отличается тем, что программа разделяется на множество одинаковых элементарных заданий. Выполнение этих заданий осуществляется на распределенных компьютерах (узлах) кластера. Затем все соединяется в единый результат.

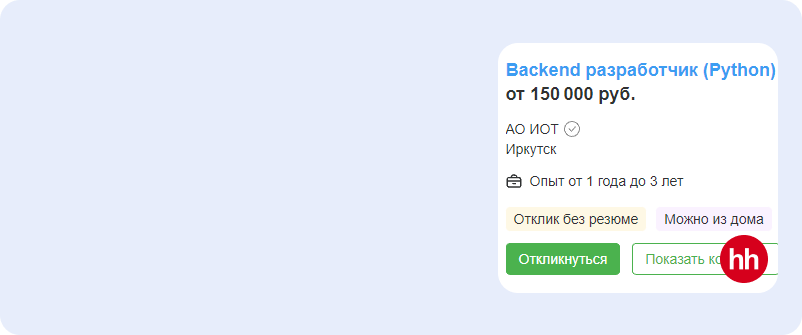

на обучение «Python-разработчик» до 01 марта

У проекта есть четыре ключевых модуля:

- Hadoop Common. Это связка инфраструктурных программных библиотек и утилит, применяющихся в других решениях и родственных проектах. Например, при управлении распределенными файлами и разработке инфраструктуры.

- HDFS. Речь идет о распределенной файловой системе, позволяющей хранить информацию на различных серверах данных (узлах, DataNodes). Их адреса размещены на специальном сервере имен (мастере, NameNode). Дублирование (репликация) информационных блоков позволяет хранить крупные файлы, которые блочно распределены между узлами вычислительного кластера.

- YARN. Данный модуль представляет собой систему планирования заданий и управления кластером (Yet Another Resource Negotiator). Ее второе название – MapReduce 2.0 (MRv2). YARN состоит из нескольких системных программ (демонов), которые обеспечивают совместное использование, масштабирование и надежность функционирования распределенных приложений. Эту систему можно назвать интерфейсом, который связывает аппаратные ресурсы кластера и приложения, задействующие его мощности при вычислении и обработке информации.

- Hadoop MapReduce. Это платформа программирования и выполнения распределенных MapReduce-вычислений. При ее работе может использоваться множество компьютеров (узлов, nodes), которые представляют собой кластер.

Некоторые дополнительные элементы:

- Hive. Это система хранения информации, с помощью которой можно запрашивать большие объемы данных в До выпуска этого решения разработчики испытывали трудности при создании сложных заданий MapReduce для запроса данных Hadoop. В Hive применяется язык запросов HQL. Его синтаксис схож с SQL.

- Pig. Этот компонент преобразовывает входные данные для получения выходной информации. Такое решение помогает на этапе подготовки данных, так как позволяет без труда выполнять сложные запросы. Pig поддерживает множество форматов данных.

- Flume. Отвечает за прием больших данных. Flume играет роль курьера, передающего сообщения между несколькими источниками информации и HDFS. Этот компонент выполняет сбор, объединение и отправку в HDFS файлов журналов, событий, созданных десктопными версиями соцсетей и др.

- Zookeeper. Это сервис-координатор и администратор Hadoop, отвечающий за распределение данных между несколькими серверами.

На данный момент сформирована целая экосистема Хадуп. Она включает в себя множество связанных проектов и технологий, применяющихся для интеллектуального анализа больших данных (Data Mining), включая машинное обучение (Machine Learning).

Основные функции Hadoop

Для чего же используется Hadoop? Рассмотрим его основные функции:

- Увеличение скорости обработки данных. Это становится возможным за счет применения модели MapReduce и параллельных вычислений.

- Обеспечение устойчивости данных. Хадуп хранит резервные копии информации на различных узлах.

- Работа с любыми видами данных. Например, с видео, которые представляют собой неструктурированную информацию.

С помощью Хадуп можно:

- Собирать сведения о действиях клиентов на веб-сайте и в магазине, анализировать их поведение. Это позволяет формировать прогнозы.

- Анализировать логи, быстро устранять сбои и нарушения безопасности, управлять рисками. Обычные хранилища обычно не справляются с большим потоком данных, которые исходят из логов.

- Обрабатывать данные от интернета вещей. К примеру, с помощью датчиков, которые находятся на различных устройствах.

ТОП-100 площадок для поиска работы от GeekBrains

ТОП-100 площадок для поиска работы от GeekBrains

20 профессий 2023 года, с доходом от 150 000 рублей

20 профессий 2023 года, с доходом от 150 000 рублей

Чек-лист «Как успешно пройти собеседование»

Чек-лист «Как успешно пройти собеседование»

Кому нужен Hadoop

Основные сферы применения Hadoop – хранение и анализ больших данных. Этот набор инструментов применяется в компаниях, работа которых связана с Big Data. Например, крупными ритейлами, соцсетями, высокотехнологичными стартапами, а также в здравоохранении, производстве и логистике.

Перечислим некоторые сферы бизнеса, в которых применяется Хадуп:

- Ритейл. Программное обеспечение позволяет собирать информацию о продажах и поведении клиентов на веб-сайте. Кроме того, Хадуп помогает хранить сведения о товарах (ассортименте, популярности, остатках на складе) и разрабатывать программы лояльности, персональные предложения, акции, схемы закупок на базе этих сведений. Ритейлеры используют Hadoop для увеличения объемов продаж.

- Производство. С помощью Hadoop можно хранить данные, полученные от датчиков на оборудовании, прогнозировать интервалы технического обслуживания, устанавливать цены на товары, снижать производственные расходы.

- Банки. В этой сфере Хадуп применяется для анализа финансовых данных и рисков. Кроме того, ПО позволяет защитить банк от мошенничества и предсказывать поведение клиентов.

- Медицина. Hadoop используется для хранения медицинской информации. Такие данные, как правило, не структурированы. Программное обеспечение позволяет увеличить прибыль больницы, правильно оценить эффективность лечения, отслеживать факторы риска заболеваний.

Для использования Хадуп специалист должен обладать навыками работы с большими данными.

Часто задаваемые вопросы о Hadoop

Кому не подойдет Хадуп?

Начинающим аналитикам данных. Дело в том, что хранилища на его основе имеются не во всех организациях. Компании, использующие Хадуп, как правило, поручают работу с этим ПО отдельным специалистам (к примеру, Data-инженерам). Однако по мере развития будет не лишним изучить данную технологию. Это увеличит шансы на успешное трудоустройство.

Как начать работать с Хадуп?

Перечислим несколько рекомендаций:

- Для начала можно посмотреть обзорные видео на YouT Так начинающий аналитик данных сможет ознакомиться с особенностями каждого инструмента.

- Не лишним будет пройти офлайн- или онлайн курсы по Hadoop. В Сети есть большое количество программ обучения для опытных аналитиков. Кроме того, есть курсы по типу “Hadoop для чайников”.

- При самостоятельном изучении рекомендуется установить на виртуальную машину образ, в которой вся экосистема уже будет настроена. Неопытный специалист может обучиться работе с Hadoop по книгам, видеоурокам и форумам. Чем больше источников информации задействует аналитик, тем лучше.

Каковы преимущества Хадуп?

Рассмотрим некоторые плюсы данной технологии:

- Масштабируемость. Компания может масштабировать ПО, добавлять новые узлы, если повышается объем информации.

- Простота. Перед сохранением информацию не требуется обрабатывать. Хадуп может использоваться для переработки неструктурированных данных любого типа (в том числе текстов, картинок и видео).

- Стабильность работы. Платформа автоматически сохраняет копии всех файлов. При возникновении сбоя информация отправляется на функционирующий узел.

- Высокая мощность. Набор инструментов Hadoop очень быстро обрабатывает данные. Чем больше применяется вычислительных узлов, тем выше мощность.

- Удобный функционал для хранения информации. Хадуп можно настроить для обработки файлов с различных ресурсов, социальных сетей организации, финансовых отчетов и т. д. При этом данные хранятся в специальных архивах. Они разработаны таким образом, чтобы пользователь мог в любое время воспользоваться содержащимися в них сведениями.

Читайте также!

Таким образом, Hadoop представляет собой набор эффективных инструментов для работы с данными. Как правило, эту платформу используют в облачном формате, чтобы упростить процесс внедрения и снизить начальные затраты.

4 019

4 019

0

0

Разберем 11 самых важных жизненных вопросов

Разберем 11 самых важных жизненных вопросов